- O modelo de linguagem grande PaLM 2 do Google usa quase cinco vezes mais dados textuais para treinamento do que seu predecessor, LLM, CNBC aprendeu.

- Ao anunciar o PaLM 2 na semana passada, o Google disse que o modelo é menor que o PaLM anterior, mas usa uma “tecnologia” mais eficiente.

- A falta de transparência sobre os dados de treinamento em modelos de IA tornou-se um tema cada vez mais discutido entre os pesquisadores.

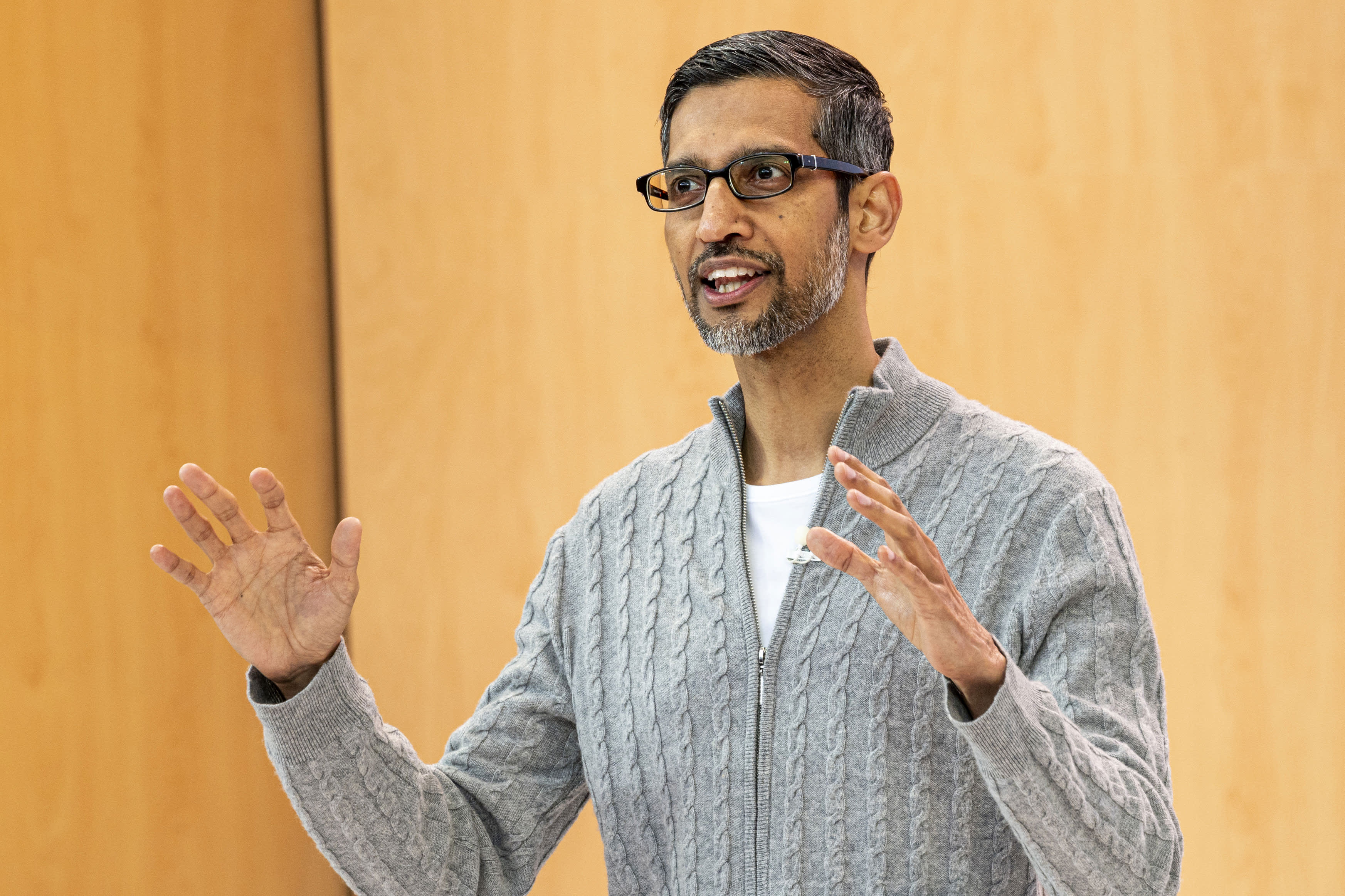

Sundar Pichai, CEO, Alphabet Inc. , durante a Google I/O Developers Conference em Mountain View, Califórnia, na quarta-feira, 10 de maio de 2023.

David Paul Morris | bloomberg | Getty Images

A CNBC descobriu que o novo modelo de linguagem grande do Google, que a empresa anunciou na semana passada, usa quase cinco vezes mais dados de treinamento do que seu antecessor de 2022, permitindo executar tarefas mais avançadas de codificação, matemática e escrita criativa.

O PaLM 2, o novo modelo de linguagem grande de uso público (LLM) da empresa revelado no Google I/O, foi treinado em 3,6 trilhões de tokens, de acordo com documentos internos vistos pela CNBC. Os tokens, que são sequências de palavras, são um bloco de construção importante para o treinamento do LLM, porque ensinam o modelo a prever a próxima palavra que aparecerá em uma sequência.

A versão anterior do PaLM do Google, que significa Pathways Language Model, foi lançada em 2022 e treinada em 780 bilhões de tokens.

Embora o Google estivesse ansioso para mostrar o poder de sua tecnologia de IA e como ela poderia ser integrada a pesquisas, e-mails, processadores de texto e planilhas, a empresa não estava disposta a publicar o volume ou outros detalhes de seus dados de treinamento. A OpenAI, inovadora do ChatGPT apoiado pela Microsoft, também manteve em segredo os detalhes da linguagem LLM mais recente, chamada GPT-4.

As empresas dizem que o motivo da falta de divulgação é a natureza competitiva do negócio. O Google e a OpenAI estão correndo para atrair usuários que desejam pesquisar informações usando chatbots em vez dos mecanismos de pesquisa tradicionais.

Mas, à medida que a corrida armamentista da IA avança, a comunidade de pesquisa pede mais transparência.

Desde a revelação do PaLM 2, o Google disse que o novo modelo é menor do que os LLMs anteriores, o que é significativo porque significa que a tecnologia da empresa está se tornando mais eficiente ao realizar tarefas mais complexas. O PaLM 2 é treinado, de acordo com a documentação interna, em 340 bilhões de parâmetros, o que é uma indicação da complexidade do modelo. O PaLM inicial é treinado em 540 bilhões de parâmetros.

O Google não forneceu comentários imediatamente para esta história.

Google Ele disse Em uma postagem no blog sobre o PaLM 2, o modelo usa uma “nova técnica” chamada Otimização de Escala Computacional. Isso torna o LLM “mais eficiente com melhor desempenho geral, incluindo inferência mais rápida, menos parâmetros de serviço e menor custo de serviço”.

Ao anunciar o PaLM 2, o Google confirmou relatórios anteriores da CNBC de que o modelo é treinado em 100 idiomas e executa uma ampla gama de tarefas. Ele já está sendo usado para alimentar 25 recursos e produtos, incluindo o chatbot experimental da empresa, Bard. Está disponível em quatro tamanhos, do menor ao maior: Gecko, Otter, Bison e Unicorn.

O PaLM 2 é mais poderoso do que qualquer modelo existente, baseado em divulgações públicas. LLM no Facebook é chamado LLaMA, que é anunciar Em fevereiro, foi treinado em 1,4 trilhão de tokens. A última vez que a OpenAI compartilhou o volume de treinamento do ChatGPT foi com o GPT-3, quando a empresa disse ter treinado 300 bilhões de códigos naquele período. A OpenAI lançou o GPT-4 em março e disse que mostra “desempenho de nível humano” em vários testes profissionais.

LaMDA, conversa LLM que o Google pé Há dois anos e promovido em fevereiro ao lado de Bard, ele foi treinado em 1,5 trilhão de tokens, de acordo com os últimos documentos vistos pela CNBC.

À medida que novos aplicativos de IA alcançam rapidamente o mainstream, o mesmo acontece com o debate sobre a tecnologia subjacente.

Mehdi Elmohamady, pesquisador sênior do Google, Ele renunciou em fevereiro Sobre a falta de transparência da empresa. Na terça-feira, o CEO da OpenAI, Sam Altman, testemunhou em uma audiência do Subcomitê Judiciário do Senado sobre Privacidade e Tecnologia e concordou com os legisladores que um novo sistema é necessário para lidar com a IA.

“Para uma tecnologia tão nova, precisamos de uma nova estrutura”, disse Altman. “Certamente empresas como a nossa têm muita responsabilidade pelas ferramentas que colocamos no mundo.”

— Jordan Novette da CNBC contribuiu para este relatório.

Ele assiste: Sam Altman, CEO da OpenAI, pediu administração de IA

“Viciado em zumbis amigo dos hipsters. Aspirante a solucionador de problemas. Entusiasta de viagens incuráveis. Aficionado por mídia social. Introvertido.”

More Stories

Uma empresa afirma que Barbie pode superar o vício em smartphones

Os jogadores reclamam do longo tempo de matchmaking no PS5 conforme os números do Concord caem

O próximo mini drone 4K da DJI cabe na palma da sua mão